CHATGPT 4o : ¿ESTAMOS ANTE LA PRIMERA INTELIGENCIA EMOCIONAL ARTIFICIAL?

“Todavía me sorprende un poco que sea real la nueva función de voz. Logra expresividad a nivel humano. Es rápido, inteligente, divertido, natural y útil.” Sam Altman, CEO OpenAI.

“Parece que estás muy feliz y alegre, incluso un poco emocionado. ¿Podrías compartir conmigo la causa de esas buenas vibraciones? [...] ¡Oh, para! Me estás haciendo sonrojar.” GPT-4o durante su presentación en OpenAI Spring Update

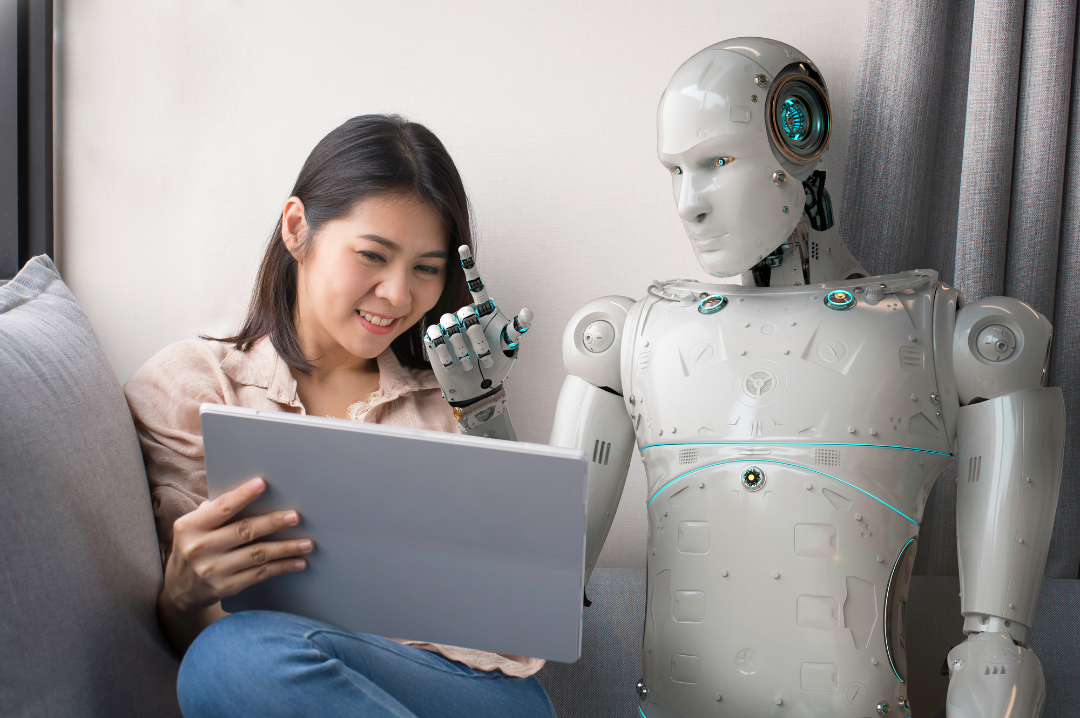

El 13 de mayo de 2024 OpenAI, una de las empresas líderes en IA a nivel global, organizó un evento retransmitido en directo con el modesto título de “OpenAI Spring Update”. En un escenario semejante a un salón de una casa, con sofás para los asistentes, Mira Murati, la responsable de tecnología, en vaqueros y zapatillas, presentó de manera casi casual la herramienta más impresionante de IA disponible de manera general: GPT-4o. La letra ‘o’, de omni, alude a las características multimodales que luego comentaremos. Puedes ver este evento en https://www.youtube.com/watch?v=DQacCB9tDaw

Algunos periodistas técnicos hablarán de su superioridad analizando datos y creando gráficas, de su ‘multimodalidad’, de su capacidad para soportar 50 idiomas, de su mayor velocidad de procesamiento, o de cómo ahora trabaja mejor como programador. Todo esto es real y se nota una importante diferencia en las pruebas que hemos realizado. Sin embargo, hay un gran salto cualitativo: nunca un asistente de inteligencia artificial de uso general ha parecido, a varios niveles, tan humano.

.png?width=450&height=450&name=Imagenes%20NL%20Mayo%20(1).png)

.png?width=350&height=350&name=Imagenes%20NL%20Mayo%20(2).png)

En primer lugar, GPT-4o es capaz de interpretar las emociones humanas. No sólo de manera teórica, en un chat en función de las palabras usadas. Puedes mostrar una foto de una o varias personas y, simplemente viendo las caras, interpretar las emociones de las personas que aparecen, una a una. También es capaz de escuchar e interpretar el tono de voz y las expresiones utilizadas para inferir emociones que sienten las personas.

En segundo lugar, GPT-4o es capaz, a su vez, de responder como lo haría una persona a nivel vocal. La nueva versión es un salto hacia adelante en su capacidad de expresar diferentes emociones con la voz: emoción, alegría, sorpresa, y con una fidelidad que parece (casi casi) estar escuchando a una persona con esas emociones. Escúchalo y juzga por ti mismo.

Como consecuencia de estas dos características, ChatGPT resulta empático, artificialmente hablando, claro. Te escucha, detecta tus emociones, te pregunta qué te pasa, y adapta su discurso al hablar, para darte ánimos cuando avanzas en una tarea, para preguntarte qué te pasa si no estás bien, o para celebrar contigo una buena noticia. En ocasiones hay que volver atrás y auto-convencerse de que estás hablando con una máquina, porque tus sentidos y tus emociones humanas a veces casi te traicionan.

Voy a terminar hablando de una de las principales características en las que están evolucionando los nuevos modelos de IA, y es lo que se denomina “multimodalidad”. Se refiere a la construcción del propio modelo, con la capacidad no solo de comunicarse por texto, sino de hablar y escuchar, y entender la voz, y de “ver” fotos o vídeos.

En la práctica esto representa el poder comunicarse con la IA como lo harías con una persona, sin necesitar ningún tipo de teclado, ratón, o pantalla táctil. Esta IA puede ver lo que tú ves como tú lo ves, y entenderlo. Y por ello puede hablar contigo de una manera tan abierta y fluida que parece casi magia. Algunos ejemplos sencillos, casi triviales, son la capacidad de resolver ejercicios simplemente fotografiando la hoja del cuaderno con los enunciados, o de recordarte dónde has dejado las gafas, si has estado caminando por tu casa con la cámara activada.

Para entender más sobre las impresionantes funcionalidades de análisis de vídeo e inteligencia artificial abstracta con un razonamiento casi humano, te invito a ver estos vídeos de demostración de Google Project Astra: Our vision for the future of AI assistants Multimodal prompting with a 44-minute movie | Gemini 1.5 Pro Demo

Cuando esperábamos un lanzamiento de un GPT todavía más inteligente realizando exámenes y tareas cognitivas, nos hemos encontrado, no sólo con eso, sino con la sorpresa de un GPT con unas capacidades emocionales y de interacción que lo hacen parecerse a una persona mucho más que nunca. Y, como diría Sam Altman, director ejecutivo de Open AI, este es el GPT más torpe que jamás tendremos, que parecerá una broma arcaica cuando lo comparemos con el GPT de dentro de dos años. Las posibilidades son tan sorprendentes como infinitas.

-Alberto Fernández

Managing Partner